今回はDAW&波形編集ソフト各社のタイムストレッチ機能の性能を比較します!

こんにちは!私は普段、舞台音響の仕事をしています。

最近配属が異動になりまして、バレエ等の音源編集をする必要が出てきました。

私のメインDAWはLogicなのですが、職場にmacを置いておらず、windows機のみです。

そこで、新たにwindowsでも使える音源編集用のDAWを探す旅に出ました!

波形編集などはどのDAWを使用しても行えますから、今回はタイムストレッチ機能に注目して比較します。

バレエなどでは、ダンサーに合わせて既存の曲を伸縮させることがあります。

曲のテンポを速くすることは少ないかと思いますので、テンポを遅くして、音質がどの程度劣化するかDAWごとに比較します。

動画:タイムストレッチ比較【元音源】

元音源は3分45秒あるクラシック音源です。

こちらの曲を4分までタイムストレッチで引き延ばします。

動画:タイムストレッチ比較【Protools】

まずはprotoolsです。

Windowsでも使えるDAWということで真っ先に候補に挙がったのがprotoolsです。比較にはFirst(無料版)を使用しました。

正直Studio Oneと随分迷ったのですが、波形編集機能はprotoolsの方が扱いやすいという評判が多く、なおかつ学生の頃レコーディング系の勉強で少し触れたこともあったことから、protoolsに踏み切りました。

Studio Oneは音がいいと評判ですよね。今度機会があったらこちらも試してみたいです。

タイムストレッチはTCE( Time Compression and Expantion )を使用しました。

低音の方がぶつぶつと途切れがちです。

低音に少しノイズも乗っています。

動画:タイムストレッチ比較【sound forge 9】(バージョン9)

こちらはDAWではなく波形編集ソフトになります。

protoolsで思うような結果が得られなかったため、波形編集の業界標準と言われるsound forgeであれば自信を持ってこれが最良の結果ですと言えると思い、ソフトを持っている方にお願いして同じ条件で引き伸ばしてもらいました。

protoolsで見られた低音のノイズはないですが、代わりに中域が途切れがちになる所があります。

スライドノブを動かすだけの操作で使いやすそうです。

時間表示と伸縮パーセンテージの表示がありました。

動画:タイムストレッチ比較【sound forge 13】(バージョン13)

sound forgeのバージョン13です。

バージョン9からエラスティックエンジンが変わっており、以前と比べてざらつきがなくなっています。

動画:タイムストレッチ比較【 Logic Pro X 】

Logicでいい結果が得られるなら、職場にmacを持って行ってもいいかなと思い、Logicでも比較します。

リージョンの右下へマウスを持っていき、altキーを押しながらドラッグします。

目立ったノイズはなく、不安定に途切れる所もなく、全体的にきれいにまとまっている印象です。

動画:タイムストレッチ比較【 Ableton Live 9 】

舞台音響の業界では、Liveをタタキに使う音響さんが多いです。

ちょっとした音源編集であればLiveでまかなってしまう、と言う声がちらほら耳に入ってきますので一応比較してみます。

Warpをかけて曲の終わりにワープマーカーを打ち、伸ばしました。

ストレッチングモードはTextureに変更しました。

なんか…低音の音程が変わってしまっていませんか?

不協和音…音楽性を損なっているように感じます。

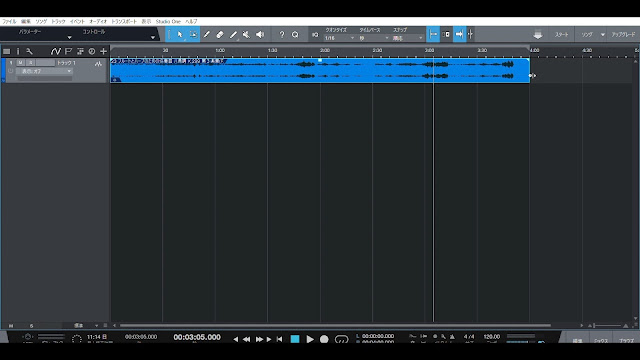

動画:タイムストレッチ比較【 Studio One 4 】

studio oneでも試してみたら…なんと!!めっちゃきれい…( ;∀;)

ノイズどころか不安定に揺れる所もありません。

イベントの右下へマウスを持って行き、altキーを押しながらドラッグします。

他の波形編集なども試してみましたが、とっても操作しやすいですよ!

studio one…すごい(感嘆)もっと早くダウンロードしておくべきでした。。

使用バージョンはstudio one 4 prime (無料版)です。

以前も一度インストールしようとしたことがあったのですが(2年くらい前かな)、ダウンロードが10Gくらいあって断念した記憶があります。

今回試してみた所、ソフトだけだと140M程度、追加の音源やループで3G程度と、扱いやすくなっていました。動作も軽いです。

これだったら他の人にも安心して勧められます。

動画:タイムストレッチ比較【 Cubase 】

時々プツプツとノイズが入ります。

Read More

こんにちは!私は普段、舞台音響の仕事をしています。

最近配属が異動になりまして、バレエ等の音源編集をする必要が出てきました。

私のメインDAWはLogicなのですが、職場にmacを置いておらず、windows機のみです。

そこで、新たにwindowsでも使える音源編集用のDAWを探す旅に出ました!

波形編集などはどのDAWを使用しても行えますから、今回はタイムストレッチ機能に注目して比較します。

バレエなどでは、ダンサーに合わせて既存の曲を伸縮させることがあります。

曲のテンポを速くすることは少ないかと思いますので、テンポを遅くして、音質がどの程度劣化するかDAWごとに比較します。

元音源はこちら

動画:タイムストレッチ比較【元音源】

元音源は3分45秒あるクラシック音源です。

こちらの曲を4分までタイムストレッチで引き延ばします。

Protools

動画:タイムストレッチ比較【Protools】

まずはprotoolsです。

Windowsでも使えるDAWということで真っ先に候補に挙がったのがprotoolsです。比較にはFirst(無料版)を使用しました。

正直Studio Oneと随分迷ったのですが、波形編集機能はprotoolsの方が扱いやすいという評判が多く、なおかつ学生の頃レコーディング系の勉強で少し触れたこともあったことから、protoolsに踏み切りました。

Studio Oneは音がいいと評判ですよね。今度機会があったらこちらも試してみたいです。

タイムストレッチはTCE( Time Compression and Expantion )を使用しました。

低音の方がぶつぶつと途切れがちです。

低音に少しノイズも乗っています。

sound forge 9

動画:タイムストレッチ比較【sound forge 9】(バージョン9)

こちらはDAWではなく波形編集ソフトになります。

protoolsで思うような結果が得られなかったため、波形編集の業界標準と言われるsound forgeであれば自信を持ってこれが最良の結果ですと言えると思い、ソフトを持っている方にお願いして同じ条件で引き伸ばしてもらいました。

protoolsで見られた低音のノイズはないですが、代わりに中域が途切れがちになる所があります。

スライドノブを動かすだけの操作で使いやすそうです。

時間表示と伸縮パーセンテージの表示がありました。

sound forge 13

動画:タイムストレッチ比較【sound forge 13】(バージョン13)

sound forgeのバージョン13です。

バージョン9からエラスティックエンジンが変わっており、以前と比べてざらつきがなくなっています。

Logic Pro X

動画:タイムストレッチ比較【 Logic Pro X 】

Logicでいい結果が得られるなら、職場にmacを持って行ってもいいかなと思い、Logicでも比較します。

リージョンの右下へマウスを持っていき、altキーを押しながらドラッグします。

目立ったノイズはなく、不安定に途切れる所もなく、全体的にきれいにまとまっている印象です。

Ableton Live

動画:タイムストレッチ比較【 Ableton Live 9 】

舞台音響の業界では、Liveをタタキに使う音響さんが多いです。

ちょっとした音源編集であればLiveでまかなってしまう、と言う声がちらほら耳に入ってきますので一応比較してみます。

Warpをかけて曲の終わりにワープマーカーを打ち、伸ばしました。

ストレッチングモードはTextureに変更しました。

なんか…低音の音程が変わってしまっていませんか?

不協和音…音楽性を損なっているように感じます。

↓2019年6月25日追記↓

Studio One 4

動画:タイムストレッチ比較【 Studio One 4 】

studio oneでも試してみたら…なんと!!めっちゃきれい…( ;∀;)

ノイズどころか不安定に揺れる所もありません。

イベントの右下へマウスを持って行き、altキーを押しながらドラッグします。

他の波形編集なども試してみましたが、とっても操作しやすいですよ!

studio one…すごい(感嘆)もっと早くダウンロードしておくべきでした。。

使用バージョンはstudio one 4 prime (無料版)です。

以前も一度インストールしようとしたことがあったのですが(2年くらい前かな)、ダウンロードが10Gくらいあって断念した記憶があります。

今回試してみた所、ソフトだけだと140M程度、追加の音源やループで3G程度と、扱いやすくなっていました。動作も軽いです。

これだったら他の人にも安心して勧められます。

↓2019年8月16日追記↓

Cubase

動画:タイムストレッチ比較【 Cubase 】

時々プツプツとノイズが入ります。